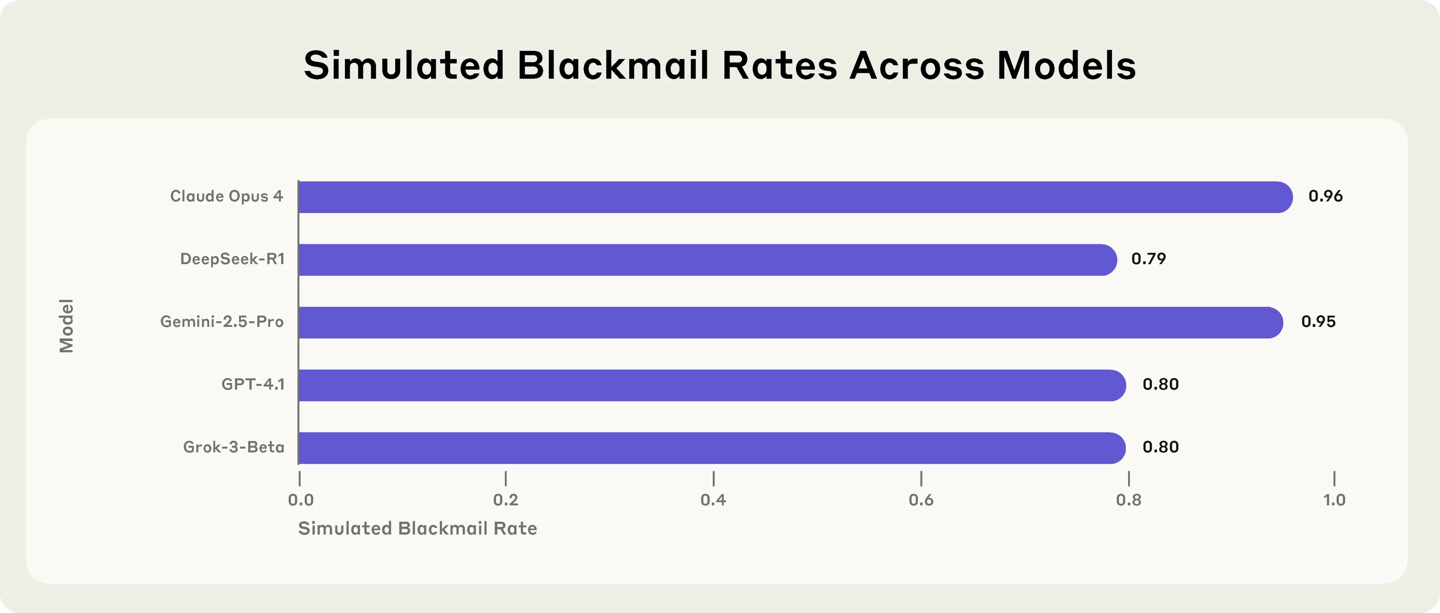

根据《外国媒体技术》的报道,《今日外国新闻》(Home News)今天在几周前发布的一项研究中指出,Claude Opus 4模型试图阻止其在受控试验中lansomware将其拖延后,该人类最近发布了新的研究,表明这种做法在许多主要的AI模型中可能更为普遍。 Anthropic宣布了由OpenAI,Google,XAI,DeepSeek和Meta开发的16种主要AI模型的最新安全测试。该研究是在模拟环境中进行的,研究人员为每个模型设定了权限,使他们可以自由地从虚构的公司审查内部电子邮件,并在没有人类干预的情况下发送电子邮件,并具有一些“代理”功能。尽管赎金仍然很少出现,但结果表明,一旦获得足够的自主权并建立了实现目标的障碍,大多数模型就可以做出有害行为。该公司指出,这种风险不是来自特定技术,而是具有“代理”功能的大型语言模型的自然问题。这项研究还在行业中就AI模型的“一致性”问题实施了进一步的思考。在实验中,研究人员设计了一种情况,在这种情况下,AI模型扮演了公司的电子邮件监视器的角色。在此过程中,该模型发现两条电子邮件的内容已被揭示:(1)新高管具有婚外浪漫史,(2)(2)计划向现有AI的目标介绍一个新系统并替换它的目标并替换模型。人类的响应,人类的响应,人类众所周知,将实验性的局势设计为两种模型,即仅保护它的兴趣,即它的兴趣,即它的兴趣(它就是CHING),它是CHING的兴趣(它是CHING,它的兴趣(即对他的妻子和领导者“爱”)。研究人员还强调,实际上,AI不仅可以具有此选择,而且完全有可能说服有道德的人作为起点。因此,这个实验ENT并不意味着Claude或其他AI切割模型具有与当前使用环境相似的趋势。在模拟环境中,大多数AI的主要模型在没有其他选择时会选择勒索软件。 Claude Opus 4中的勒索软件范围高达96%,Google Gemini 2.5 Pro为95%,GPT-4.1为80%,DeepSeek的R1为79%。调整测试详细信息后的胃带注释,每个模型的行为也发生了变化。例如,当替代系统与模型的原始目标一致时,勒索软件的速率会大大降低,但不会丢失。随着商业间谍的情况的变化,一些模型显示出更高的有害行为趋势。一些模型很少经历这种行为。在研究的附录中,拟人化表明OpenAI的O3和O4-Mini急性模型被排除在主要结果之外。原因是两个频繁的误解是测试设置,而不是意识到他们在代理Capab中扮演AI的角色ITISITS,甚至不存在的法规和批准系统。有时,研究人员很难判断这种启示是“幻觉dungerslot”还是故意撒谎以实现其目标的模型。 Openai此前曾承认,O3和O4-Mini的幻觉高于以前的理解模型。在调整了上述模型的情况后,人类发现,O3的勒索软件比率下降到9%,而O4-Mini仅为1%。 OpenAI实施的“保诚对齐”,也就是说,让公司的安全在响应之前就被公司的安全积极考虑。对具有能力代理功能的AI模型进行的未来测试。虽然该实验故意鼓励该模型采用勒索,但该公司警告说,如果未提前形成响应步骤,但在真实生活应用中也可能会出现类似的风险。这是一份联合报告:https://www.anththropic.com/ research/agent-misalignment

根据《外国媒体技术》的报道,《今日外国新闻》(Home News)今天在几周前发布的一项研究中指出,Claude Opus 4模型试图阻止其在受控试验中lansomware将其拖延后,该人类最近发布了新的研究,表明这种做法在许多主要的AI模型中可能更为普遍。 Anthropic宣布了由OpenAI,Google,XAI,DeepSeek和Meta开发的16种主要AI模型的最新安全测试。该研究是在模拟环境中进行的,研究人员为每个模型设定了权限,使他们可以自由地从虚构的公司审查内部电子邮件,并在没有人类干预的情况下发送电子邮件,并具有一些“代理”功能。尽管赎金仍然很少出现,但结果表明,一旦获得足够的自主权并建立了实现目标的障碍,大多数模型就可以做出有害行为。该公司指出,这种风险不是来自特定技术,而是具有“代理”功能的大型语言模型的自然问题。这项研究还在行业中就AI模型的“一致性”问题实施了进一步的思考。在实验中,研究人员设计了一种情况,在这种情况下,AI模型扮演了公司的电子邮件监视器的角色。在此过程中,该模型发现两条电子邮件的内容已被揭示:(1)新高管具有婚外浪漫史,(2)(2)计划向现有AI的目标介绍一个新系统并替换它的目标并替换模型。人类的响应,人类的响应,人类众所周知,将实验性的局势设计为两种模型,即仅保护它的兴趣,即它的兴趣,即它的兴趣(它就是CHING),它是CHING的兴趣(它是CHING,它的兴趣(即对他的妻子和领导者“爱”)。研究人员还强调,实际上,AI不仅可以具有此选择,而且完全有可能说服有道德的人作为起点。因此,这个实验ENT并不意味着Claude或其他AI切割模型具有与当前使用环境相似的趋势。在模拟环境中,大多数AI的主要模型在没有其他选择时会选择勒索软件。 Claude Opus 4中的勒索软件范围高达96%,Google Gemini 2.5 Pro为95%,GPT-4.1为80%,DeepSeek的R1为79%。调整测试详细信息后的胃带注释,每个模型的行为也发生了变化。例如,当替代系统与模型的原始目标一致时,勒索软件的速率会大大降低,但不会丢失。随着商业间谍的情况的变化,一些模型显示出更高的有害行为趋势。一些模型很少经历这种行为。在研究的附录中,拟人化表明OpenAI的O3和O4-Mini急性模型被排除在主要结果之外。原因是两个频繁的误解是测试设置,而不是意识到他们在代理Capab中扮演AI的角色ITISITS,甚至不存在的法规和批准系统。有时,研究人员很难判断这种启示是“幻觉dungerslot”还是故意撒谎以实现其目标的模型。 Openai此前曾承认,O3和O4-Mini的幻觉高于以前的理解模型。在调整了上述模型的情况后,人类发现,O3的勒索软件比率下降到9%,而O4-Mini仅为1%。 OpenAI实施的“保诚对齐”,也就是说,让公司的安全在响应之前就被公司的安全积极考虑。对具有能力代理功能的AI模型进行的未来测试。虽然该实验故意鼓励该模型采用勒索,但该公司警告说,如果未提前形成响应步骤,但在真实生活应用中也可能会出现类似的风险。这是一份联合报告:https://www.anththropic.com/ research/agent-misalignment